Why we need GraphRAG: Traditional RAG vs. GraphRAG

Background: Traditional RAG System

Knowledge Organization: Preparing Metadata.

- 일반적인 전략: Text Chunking

- 방대한 텍스트 코퍼스(corpus)를 관리하기 쉬운 '청크(chunks)'라는 작은 단위로 분할.

- 이 청크들은 임베딩(embedding) 모델을 사용하여 벡터(vector) 표현으로 변환됩니다.

- 이렇게 생성된 임베딩은 벡터 데이터베이스(vector database)에서 원본 텍스트 청크의 '키(key)' 역할을 합니다.

- Semantic Chunking: 시맨틱 공간(semantic space)에서의 거리 기반 검색(distance-based search)을 통한 효율적인 정보 조회 및 검색이 가능해집니다.

- 지식 구성 최적화: 검색 전 단계에서 외부 지식 구성을 최적화하기 위한 여러 방법이 제안되었습니다.

- 과립성 최적화(Granularity Optimization)

- 관련성(relevance)과 효율성(efficiency) 사이의 균형을 맞추는 것이 목표입니다.

- 과립성(granularity) 이 큰 단위(e.g., 길이가 긴 청크)는 풍부한 문맥을 제공하지만, 중복되거나 불필요한 정보로 인해 방해가 될 수 있습니다.

- 과립성(granularity) 이 작은 단위(e.g., 길이가 짧은 청크)는 시맨틱 무결성(semantic integrity)이 부족하거나 검색 부담을 증가시킬 수 있습니다.

- 토큰(token) 제한에 따라 문서를 청크로 분할하는 청킹 전략(chunking strategies) 을 사용합니다.

- 대표적인 방법으로는 recursive splits, sliding windows, Small-to-Big 등이 있으며, 문맥 길이(context length)를 최적화하면서 semantic completeness 을 유지하려 노력합니다.

- 인덱싱 최적화(Indexing Optimization)

- 검색을 위한 콘텐츠의 구조와 품질을 개선하는 데 중점을 둡니다.

- 메타데이터 추가(Metadata-addition): 제목, 타임스탬프, 카테고리, 키워드와 같은 메타데이터를 청크 텍스트에 첨부하여 검색 후 필터링(filtering) 및 재순위화(re-ranking) 작업을 가능하게 합니다.

- 계층적 인덱싱(Hierarchical indexing): 파일을 부모-자식 관계(parent-child relationships)로 구성하고 각 노드에 요약(summaries)을 포함시켜 더 빠르고 효율적인 데이터 탐색을 용이하게 하며 검색 오류를 줄입니다.

- 이러한 트리(tree)와 같은 인덱싱 방법은 구조화된 지식 구성의 초기 시도였으며, 이후 GraphRAG와 같이 그래프 구조의 강력한 기능을 활용한 지식 구성 방법의 발전에 영감을 주었습니다.

- 과립성 최적화(Granularity Optimization)

Knowledge Retrieval.

- Retrieval Stage 목표: 사전에 잘 구성된 지식 저장소(pre-organized repositories)에서 필요한 지식을 효율적으로 찾아내고 검색하는 것입니다. 이는 LLM(Large Language Model)이 생성하는 결과물의 품질을 높이는 데 기여합니다.

- 일반적인 검색 방법

- k-최근접 이웃 검색 (k-nearest neighbor retrieval, KNN): 주어진 쿼리와 가장 유사한 k개의 이웃을 찾아내는 방법입니다.

- RETRO [31]는 L2 거리를 계산하여 키-값 데이터베이스에서 유사한 이웃을 추출합니다.

- TF-IDF: 문서 내 특정 용어의 중요도를 측정하는 통계적 방법으로, 검색 관련성을 판단하는 데 사용됩니다.

- BM25 (Best Matching 25): TF-IDF를 기반으로 문서의 관련성을 순위 매기는 알고리즘입니다.

- 정확도 및 효율성 향상을 위한 전문 기법

- 다양한 문맥 생성 (Diverse Context Generation): GAR [41]은 초기 쿼리에 추가적인 문맥을 더하여 쿼리의 다양한 측면을 포착합니다. 이렇게 확장된 쿼리를 기반으로 BM25와 같은 검색 기법을 적용합니다.

- 재순위화 (Re-ranking): EAR [42]은 여러 확장된 쿼리에서 최적의 후보를 선택하기 위해 재순위화 프로세스를 구현하여 검색 정확도를 높입니다.

- 하이브리드 접근 방식 (Hybrid Approach): [43]은 BM25와 같은 정확한 검색 방법의 계산적 문제점을 해결하기 위해 하이브리드 방식을 제안합니다. 이는 sentence transformers 를 사용하여 대략적인 이웃을 식별한 다음, BM25를 통해 재순위화하여 정확성과 계산 효율성 사이의 균형을 맞춥니다.

Knowledge Integration.

- Knowledge Integration

- RAG(Retrieval-Augmented Generation) 프레임워크에서 검색된 외부 지식과 LLM(Large Language Model)이 자체적으로 보유한 지식을 결합하여, 사용자 질문에 대해 일관성 있고 정확하며 유용한 답변을 생성하는 단계

- 이 단계에서는 LLM이 최종 출력을 생성하며, 생성된 답변의 품질과 효율성을 높이기 위한 다양한 전처리 및 효율성 전략이 활용됩니다.

- 관련성 및 효율성 향상 전략

- LeanContext [113]: 강화 학습(reinforcement learning)을 사용하여 질의에 가장 적합한 문장을 선별적으로 선택합니다. 이를 통해 불필요한 컨텍스트 크기를 최소화하고 계산 비용을 절감합니다.

- SELF-RAG [16]: 언어 모델이 스스로 생성한 답변과 검색된 콘텐츠를 평가하는 자기 성찰(self-reflection) 메커니즘을 도입합니다. 이는 생성 과정에서 오류를 발견하고 교정 조치를 취할 수 있도록 돕습니다.

- SKR (Self-Knowledge Guided Retrieval Augmentation) [114]: LLM이 이미 알고 있는 질문에 대해서는 사전 학습된 지식을 활용하고, 필요한 경우에만 검색(retrieval)에 의존하는 동적 프레임워크를 제안합니다. 이는 불필요한 검색을 줄여 효율성을 높입니다.

- FILCO (Filter Context) [115]: 관련 없는 데이터를 걸러내는 컨텍스트 필터링 모델을 학습시켜 환각(hallucination) 발생 위험을 줄입니다.

- Lyu et al. [116]: 검색된 콘텐츠의 중요도를 평가하는 방법을 제시합니다. 이 연구는 검색 코퍼스의 일부를 가지치기(pruning)하거나 중요도에 따라 가중치를 재조정(re-weighting)함으로써, 추가적인 학습 없이도 RAG 시스템의 성능을 향상시킬 수 있음을 보여줍니다.

- Selfmem [117]: 검색 코퍼스가 제한적인 경우, LLM이 생성한 결과로부터 메모리 풀을 구성합니다. 이는 반복적인 선택 프레임워크를 통해 생성 품질을 향상시키는 데 기여합니다.

- SAIL (Search-Augmented Instruction Learning) [118]: 검색 결과를 기반으로 명령어 튜닝(instruction-tuning) 데이터셋을 구성하여 LLM을 미세 조정합니다. 이를 통해 LLM이 신뢰할 수 있는 콘텐츠를 기반으로 응답을 생성하고 방해되는 요소들을 제외하도록 돕습니다.

Limitations of Traditional RAG

Complex Query Understanding.

- 지식 구성의 한계 (벡터 데이터베이스)

- 기존 RAG는 지식을 벡터 데이터베이스에 저장하며, 쿼리가 들어오면 주어진 쿼리와 의미적으로 유사한 text chunks 만 검색

- 이러한 텍스트 덩어리 내의 국소적인 문맥 정보만으로는 여러 단계의 추론(multi-hop questions)이 필요한 복잡한 질문에 답하기 어렵습니다.

- 특히 텍스트 덩어리의 크기(granularity)가 작아질수록 이러한 문제는 더욱 심화됩니다. 이는 전문 분야 지식처럼 복잡한 다단계 추론이 필요한 경우에 특히 문제가 됩니다.

- 기존 개선 시도의 한계

- 일부 기존 RAG 방법들은 이러한 한계를 극복하기 위해 노력했습니다. 예를 들어, GAR [41] 처럼 검색 전에 쿼리를 보강하거나, EAR [42] 처럼 여러 쿼리 후보를 재정렬하는 방식을 사용

- [35] 과 같이 메타데이터를 활용하여 더 풍부한 정보를 제공하려는 시도도 있었습니다. 하지만 이러한 방법들은 여전히 외부 지식 데이터 베이스 구성 방식이 text chunking 에 기반하고 있다는 근본적인 한계를 벗어나지 못했습니다. 이로 인해 복잡한 쿼리에 필요한 다단계 정보를 효과적으로 포착하기 어렵습니다.

- 기존 RAG의 이러한 한계는 GraphRAG와 같은 새로운 접근 방식이 부상하는 배경이 됩니다. GraphRAG는 지식 그래프(Knowledge Graphs)를 활용하여 개체 간의 관계와 계층 구조를 명시적으로 나타냄으로써, 다단계 추론과 문맥 이해를 개선하려는 목표를 가지고 있습니다.

Distributed Domain Knowledge.

- 전문 용어 및 문맥 이해의 어려움

- 특정 도메인의 질문에는 해당 분야의 전문 용어가 포함되어 문맥적 이해가 필수적입니다.

- 도메인 지식은 다양한 문서와 데이터 소스에 드문드문 분산되어 있습니다.

- Text Chunking 기반 벡터 DB 방식의 한계: 기존 RAG는 복잡성을 관리하고 인덱싱 효율성을 높이기 위해 문서를 작은 chunk 로 나눕니다. 하지만 이 과정에서 중요한 문맥 정보가 손실되어 검색 정확도와 문맥 이해도가 크게 저하될 수 있습니다.

- 계층적 구조의 부재

- 벡터 데이터베이스는 텍스트 청크를 저장하지만, 모호하거나 추상적인 개념에 대한 계층적 조직이 부족합니다.

- 분산된 개념들을 연결해야 하는 복잡한 질문을 해결하기 어렵고, 특정 도메인 전문 지식 활용 효율성이 떨어집니다.

- 지식 연결성 부족

- 일부 기존 RAG는 검색된 콘텐츠를 실시간 생성 상태에 맞춰 조정하거나 외부 API를 통해 보조 정보를 제공하기도 합니다.

그러나 이러한 방식도 여전히 청킹 기반의 지식 구성을 사용하기 때문에, 여러 지식 조각들 간의 견고한 연결을 구축하는 데는 한계가 있습니다. - 분산된 도메인 지식을 충분히 다루지 못하게 될 수 있다

- 일부 기존 RAG는 검색된 콘텐츠를 실시간 생성 상태에 맞춰 조정하거나 외부 API를 통해 보조 정보를 제공하기도 합니다.

Inherent constraints of LLMs.

- 과도하고 불필요한 정보

- 전통적인 RAG는 주로 벡터 유사성(vector similarity) 기반의 검색 모듈을 사용합니다.

- 방대한 지식 기반에서 너무 많은 정보를 검색하여, 실제로는 불필요하거나 관련 없는 내용이 포함될 수 있습니다.

- LLM의 컨텍스트 윈도우(Context Window) 한계

- LLM은 한 번에 처리할 수 있는 입력 길이, 즉 컨텍스트 윈도우가 제한되어 있습니다(일반적으로 2K-32K 토큰). 이러한 한계 때문에 LLM은 검색된 과도한 정보 중에서 실제로 필요한 것을 효과적으로 포착하기 어렵습니다.

- 복잡한 문서 내의 장거리 의존성(long-range dependencies)을 완전히 파악하는 데 어려움을 겪습니다.

- Chunk 세분화의 문제점: 정보를 더 작은 청크로 세분화하여 LLM의 컨텍스트 길이를 최적화하려는 시도(예: recursive splits, sliding windows, Small-to-Big 기법)가 있었습니다. 그러나 이러한 접근 방식은 계산 비용과 응답 지연 시간(latency)을 크게 증가시키는 단점이 있습니다.

- 색인 기반 방법의 비효율성

- 색인 기반(indexing-based) 방법은 검색 과정에서 불필요한 정보를 효과적으로 가지치기(prune)하지 못합니다.

- 이로 인해 필요한 핵심 지식이 방대한 양의 불필요한 정보에 묻혀버리는 문제가 발생할 수 있습니다.

- 장거리 의존성 포착의 어려움 (Capturing long-distance dependencies)

- 기존 RAG는 검색된 정보를 필터링하고 LLM을 미세 조정하여 품질을 높이려 했지만, 벡터 유사성 기반 검색의 본질적인 한계 때문에 검색된 콘텐츠들 사이의 명확한 연결성을 설정하기 어렵습니다.

- 결과적으로 LLM이 장거리 의존성을 이해하는 데 여전히 부족함을 보입니다.

Efficiency and scalability.

- Problem Definition: 대규모 지식 소스는 도메인과 관련 없는 정보(non-domain-specific information)를 많이 포함하고 있으며, 도메인 특화 용어(domain-specific terms)는 다양한 지식 전달자(knowledge carriers)에 걸쳐 드문드문 분포되어 있습니다.

- 검색 모듈의 부담: 이러한 특성 때문에 RAG 시스템의 검색 모듈은 관련 정보를 찾기 위해 방대한 양의 비정형 텍스트(unstructured text)를 검색해야 합니다.

- 비효율성: 이 과정은 상당한 컴퓨팅 자원(computational resources)과 시간을 소모하여 시스템의 효율성을 저하시킵니다.

- 기존 해결책의 한계

- 일부 기존 RAG 방식들은 검색 전에 전처리(preprocessing)를 통해 비용을 줄이거나, 병렬 처리(parallelism solutions)를 통해 자원 사용을 최적화하려는 시도를 했습니다.

- 하지만 이러한 방법들조차 결국에는 대량의 비정형 텍스트에서 정보를 검색해야 한다는 근본적인 한계를 가집니다.

- 지속적인 문제: 결과적으로 계산 리소스 소비와 확장성(scalability)은 기존 RAG의 지속적인 문제점으로 남아 있습니다. 이는 시스템의 성능과 실제 적용 가능성에 큰 영향을 미칩니다.

Traditional RAG vs. GraphRAG

Enhanced Knowledge Representation.

- 그래프 구조를 활용한 지식 표현

- GraphRAG는 지식을 표현하기 위해 그래프 구조를 사용합니다.

- 엔터티(개체)와 개념 간의 복잡한 관계를 노드(node)와 엣지(edge) 형태로 명시적으로 포착합니다.

- Naive RAG 와의 차이: 전통적인 RAG는 정보를 단순히 평면적인 문서(flat document-based) 형태로 표현합니다. 이는 단어 또는 구절의 유사성에 주로 의존하여 정보를 검색하기 때문에, 복잡한 지식 간의 관계를 파악하기 어렵습니다.

- Graph-based Knowledge Representation

- 풍부한 문맥 이해 및 관계 파악: GraphRAG의 그래프 구조는 다음과 같은 방식으로 지식 이해를 심화시킵니다.

- 계층 및 연관성 표현: 정보의 계층적 구조(예: 상위 개념-하위 개념)와 다양한 연관성(예: 원인-결과, 부분-전체)을 명확하게 나타낼 수 있습니다.

- 다단계 관계(Multi-hop Relationships) 포착: 여러 단계를 거쳐 연결되는 복잡한 관계(예: A가 B와 관련 있고, B가 C와 관련 있을 때 A와 C의 관계)를 효과적으로 모델링합니다. 이는 전통적인 RAG가 놓치기 쉬운 '숨겨진 연결'을 발견하는 데 도움을 줍니다.

- 풍부한 의미론적 문맥 제공: 쿼리에 대해 단순히 유사한 텍스트 덩어리를 가져오는 것을 넘어, 해당 쿼리가 속한 전체 지식 네트워크 내에서 더 풍부한 의미론적 문맥을 제공합니다.

- 통찰력 및 발견: 복잡한 관계와 숨겨진 연결을 파악하는 능력은 새로운 통찰력과 발견으로 이어질 수 있으며, 이는 연구 및 분석과 같은 분야에서 특히 유용합니다.

- 모호한 쿼리 처리: 그래프 내에서 여러 가능한 해석이나 관계를 표현할 수 있기 때문에, 모호한 쿼리에 대해서도 다양한 의미 경로를 탐색하여 보다 미묘하고 정확한 응답을 제공할 수 있습니다.

Flexibility in Knowledge Sources.

- 다양한 지식 소스 통합

- 정형 데이터(Structured data): 관계형 데이터베이스와 같이 미리 정의된 스키마에 따라 정리된 데이터를 포함합니다.

- 반정형 데이터(Semi-structured data): JSON, XML과 같이 구조가 유연하지만 계층적인 형태로 정리된 데이터를 포함합니다.

- 비정형 텍스트(Unstructured text): 일반 문서, 보고서, 웹 페이지 등 특정한 구조 없이 자유로운 형태로 작성된 텍스트를 포함합니다.

- 통합된 지식 뷰 제공: GraphRAG는 이처럼 이질적인 데이터 타입들을 하나의 그래프 구조로 연결하고 표현함으로써, 조직의 지식에 대한 통합적인 시각을 제공합니다. 이는 숨겨진 관계나 패턴을 발견하는 데 도움을 줍니다.

- Multi-modality 데이터 통합

- 텍스트뿐만 아니라 이미지, 수치 데이터 등 다양한 모달리티(양식)의 데이터를 단일 그래프 구조 내에 통합할 수 있습니다.

- 이러한 Multi-modality 통합 능력은 더욱 포괄적인 지식 표현을 가능하게 하며, 여러 데이터 양식에 걸쳐 있는 복합적인 질문(e.g., "이 제품 이미지에 나타난 기능의 과거 판매량은 얼마인가?")에 대해서도 응답할 수 있는 능력을 제공합니다.

Efficiency and Scalability.

- 대규모 데이터 처리 능력

- GraphRAG는 GraphDB 를 기반으로 구축되어 대규모 데이터셋을 효율적으로 처리할 수 있습니다.

- GraphDB 는 본질적으로 관계 기반 쿼리에 최적화되어 있어, 복잡한 데이터 구조를 빠르게 탐색하는 데 강점을 가집니다. 이는 여러 관계를 탐색해야 하는 쿼리에서 특히 빠른 응답 시간으로 이어집니다.

- 자원 효율성 및 속도 향상

- 연구에 따르면 GraphRAG 시스템은 LLM 응답을 생성할 때 전통적인 RAG 방식에 비해 26%에서 97% 더 적은 토큰을 사용할 수 있습니다.

- 이는 생성 속도 향상뿐만 아니라 자원 활용 효율성에도 상당한 개선을 가져옵니다.

- 손쉬운 지식 베이스 업데이트

- GraphRAG 시스템은 지식 베이스(Knowledge Base)의 업데이트를 훨씬 쉽게 처리합니다.

- 새로운 정보는 전체 지식 베이스를 다시 인덱싱할 필요 없이 그래프에 노드나 엣지로 추가될 수 있습니다.

- 이러한 특성 덕분에 시스템은 항상 가장 최신 정보에 접근할 수 있으며, 실시간 업데이트가 가능합니다.

- 향상된 문맥 인지 및 정확성

- 그래프 구조는 GraphRAG가 쿼리의 문맥을 더 효과적으로 고려하도록 돕습니다.

- 단순한 키워드 매칭이나 벡터 유사성에만 의존하는 대신, 그래프 내의 '의미론적 관계'를 활용하여 더 관련성 높은 정보를 검색할 수 있습니다. 이러한 문맥 인지 능력은 LLM이 더 정확하고 적절한 응답을 생성하도록 합니다.

Interpretability.

- 명시적인 지식 표현 (KG): GraphRAG는 지식(Knowledge Graphs 참조)을 노드(entities)와 엣지(relationships)로 구성된 그래프 형태로 구조화합니다. 이 구조는 일반적인 텍스트 기반 RAG 시스템이 사용하는 단순한 텍스트 덩어리(chunk)나 벡터 임베딩(vector embeddings)과는 다르게, 정보 간의 복잡한 관계를 명시적으로 보여줍니다.

- 추론 경로의 시각화: 시스템이 특정 질문에 대한 답변을 생성할 때, GraphRAG는 지식 그래프 내에서 어떤 엔터티와 관계를 참고하고 연결하여 추론을 수행했는지 그 경로를 명확하게 시각화할 수 있습니다.

- 투명성과 신뢰도 향상: 추론경로의 시각화로 인한 투명성은 AI 시스템에 대한 사용자의 신뢰를 높이는 데 결정적인 역할을 합니다. 특히 의료, 금융, 법률과 같이 오류가 심각한 결과를 초래할 수 있는 분야에서는 시스템의 결정이 어떻게 도출되었는지 검증하고 이해할 수 있어야 합니다. GraphRAG는 이러한 감사 가능성(auditable)을 제공하여 중요한 의사결정 과정에서 AI의 활용을 더욱 안전하고 신뢰할 수 있게 만듭니다.

- 문맥 이해 증진: 키워드 매칭이나 벡터 유사성에만 의존하지 않고 그래프의 의미적 관계를 활용하여 더 관련성 높은 정보를 검색하기 때문에, GraphRAG는 단순히 유사한 정보를 찾는 것을 넘어 정보 간의 논리적인 연결을 통해 문맥을 더 깊이 이해하고, 그 이해 과정을 사용자에게 보여줄 수 있습니다.

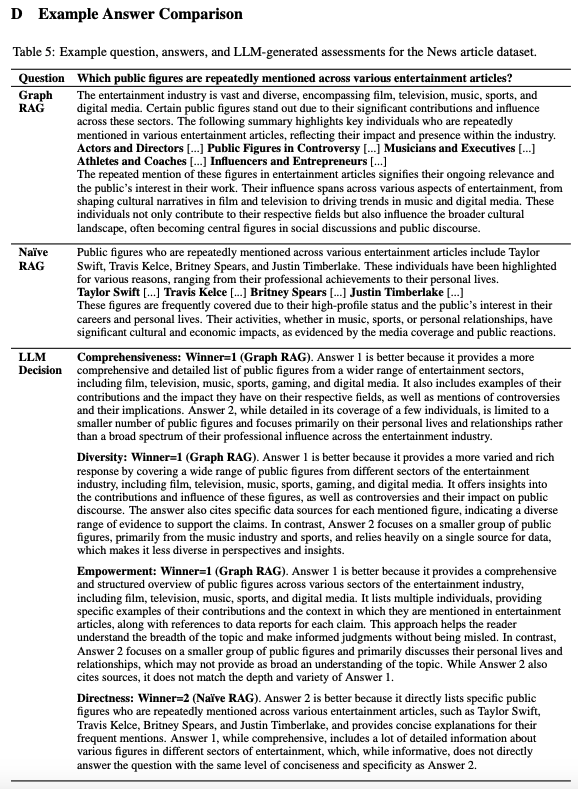

GraphRAG Case Study

From Local to Global: A GraphRAG Approach to Query-Focused Summarization

- 사용한 외부 지식 데이터 코퍼스: entertainment, business, sports, technology, health, science 의 카테고리가 포함된 News article

- Query: 다양한 연예 기사에서 반복적으로 언급되는 유명 인사는 누구입니까?

- Answer

- Naive RAG: 다양한 엔터테인먼트 기사에서 반복적으로 언급되는 유명 인사로는 테일러 스위프트, 트래비스 켈스, 브리트니 스피어스, 저스틴 팀버레이크 등이 있습니다. 이러한 인물들은 직업적 성취부터 개인 생활까지 다양한 이유로 주목받고 있습니다. 테일러 스위프트 [...] 트래비스 켈스 [...] 브리트니 스피어스 [...] 저스틴 팀버레이크 [...] 이러한 인물들은 높은 인지도와 대중의 관심으로 인해 자주 다뤄집니다. 음악, 스포츠, 개인적인 관계 등 다양한 활동을 하고 있습니다. 언론 보도와 대중의 반응에서 알 수 있듯이 문화적, 경제적으로 큰 영향을 미칩니다.

- GraphRAG by Microsoft: 엔터테인먼트 산업은 영화, 텔레비전, 음악, 스포츠, 디지털 미디어를 포함하여 방대하고 다양합니다. 특정 유명 인사들은 이러한 부문 전반에 걸쳐 상당한 기여와 영향력으로 인해 눈에 띕니다. 다음 요약은 다양한 엔터테인먼트 기사에서 반복적으로 언급되는 주요 인물들을 조명하여 업계 내 영향력과 존재감을 반영합니다. 배우 및 감독 [...] 논란의 인물 [...] 뮤지션 및 임원 [...] 운동선수 및 코치 [...] 인플루언서 및 기업가 [...] 엔터테인먼트 기사에서 이러한 수치가 반복적으로 언급되는 것은 그들의 지속적인 관련성과 대중의 작품에 대한 관심을 의미합니다. 이들의 영향력은 영화와 텔레비전의 문화적 서사 형성부터 음악과 디지털 미디어의 트렌드를 이끄는 데 이르기까지 엔터테인먼트의 다양한 측면에 걸쳐 있습니다. 개인은 각자의 분야에 기여할 뿐만 아니라 더 넓은 문화적 환경에도 영향을 미치며, 종종 사회적 토론과 공적 담론의 중심 인물이 됩니다.

- LLM Decision 평가

- Comprehensiveness: GraphRAG 은 영화, 텔레비전, 음악, 스포츠, 게임, 디지털 미디어 등 다양한 엔터테인먼트 분야의 공인들을 보다 포괄적이고 상세하게 나열하고 있기 때문에 더 좋습니다. 또한 이들의 기여와 각 분야에 미치는 영향에 대한 예시, 논란 및 그 함의에 대한 언급도 포함되어 있습니다. Naive RAG는 소수의 공인을 대상으로 자세히 다루고 있지만, 엔터테인먼트 산업 전반에 걸친 광범위한 전문적 영향보다는 주로 개인의 삶과 관계에 초점을 맞추고 있습니다.

- Diversity: GraphRAG 은 더 다양하고 풍부한 정보를 제공하기 때문에 더 좋습니다. 영화, 텔레비전, 음악, 스포츠, 게임, 디지털 미디어 등 엔터테인먼트 산업의 다양한 부문에서 온 다양한 공인들을 대상으로 대응합니다. 이는 이러한 인물들의 기여와 영향, 논란과 공적 담론에 미치는 영향에 대한 인사이트를 제공합니다. 또한 각 인물에 대한 구체적인 데이터 출처를 인용하여 이러한 주장을 뒷받침할 수 있는 다양한 증거를 제시합니다. 반면, Naive RAG 는 소수의 공인 그룹에 초점을 맞추고 있습니다. 주로 음악 산업과 스포츠 분야에서 수집된 수치로, 단일 데이터 소스에 크게 의존하기 때문에 관점과 인사이트의 다양성이 떨어집니다.

- Empowerment: GraphRAG 은 영화, 텔레비전, 음악, 스포츠, 디지털 미디어 등 엔터테인먼트 산업의 다양한 부문에서 공인에 대한 포괄적이고 체계적인 개요를 제공하기 때문에 더 좋습니다. 여러 개인을 나열하여 그들의 기여와 연예 기사에 언급된 맥락에 대한 구체적인 예를 제공하고 각 주장에 대한 데이터 보고서를 참조합니다. 이 접근 방식은 독자가 주제의 폭을 이해하고 오해를 받지 않고 정보에 입각한 판단을 내리는 데 도움이 됩니다. 반면, Naive RAG 는 소수의 공인 그룹에 초점을 맞추고 주로 개인의 삶과 관계에 대해 논의하는데, 이는 주제에 대한 폭넓은 이해를 제공하지 못할 수 있습니다. Naive RAG 는 출처를 인용하기도 하지만 GraphRAG 의 깊이와 다양성에는 부합하지 않습니다

- Directness: Naive RAG 는 테일러 스위프트, 트래비스 켈스, 브리트니 스피어스, 저스틴 팀버레이크 등 다양한 엔터테인먼트 기사에서 반복적으로 언급되는 특정 공인을 직접 나열하고, 빈번하게 언급되는 인물에 대한 간결한 설명을 제공하기 때문에 더 좋습니다. GraphRAG 은 종합적이면서도 엔터테인먼트 분야별로 다양한 인물에 대한 자세한 정보를 많이 포함하고 있어 유익하지만 Naive RAG 와 같은 수준의 간결함과 구체성으로 직접 답변하지는 않습니다.

- Directness 평가요소

- 정의: 답변이 질문에 얼마나 명확하고 구체적으로 초점을 맞추고 있는지를 평가합니다. 즉, 불필요한 정보 없이 질문에 대한 핵심을 얼마나 간결하게 전달하는지를 측정합니다.

- 용도: Directness 는 다른 평가 기준인 'Comprehensiveness(포괄성)'와 'Diversity(다양성)'의 결과를 판단하는 데 있어 참조점 역할을 하는 '통제 기준(control criterion)'으로 사용됩니다.

- 평가 방식

- LLM(LLM-as-a-judge 방식) 에게 특정 질문과 해당 질문에 대한 두 개의 다른 시스템이 생성한 답변을 제공합니다.

- LLM은 Directness 기준에 따라 두 답변을 비교하고, 어느 답변이 더 직접적인지를 판단하여 승자(또는 무승부)를 결정합니다.

- 관계: Directness 는 'Comprehensiveness' 및 'Diversity'와 상반되는 경향이 있습니다. 즉, 답변이 매우 상세하고 다양한 정보를 담고 있다면(포괄적이고 다양하다면), 질문에 대한 직접적인 핵심만 담고 있지 않을 수 있으며, 반대로 매우 직접적이고 간결하다면 중요한 세부 정보나 다양한 관점을 놓칠 수 있습니다.

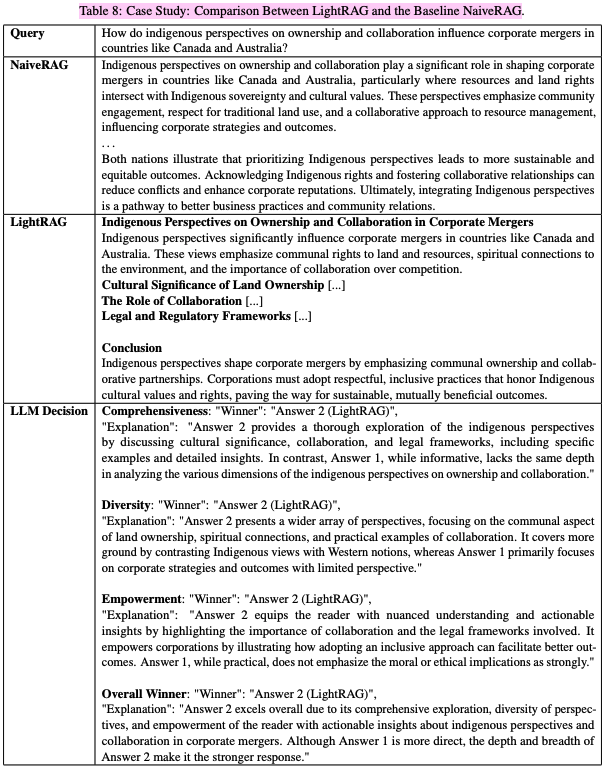

LightRAG: Simple and Fast Retrieval-Augmented Generation (EMNLP 2025)

- 실험에 사용한 데이터셋: UltraDomain benchmark, covering diverse domains such as Agriculture, CS, Legal, and Mixed.

- Query: 소유권과 협업에 대한 원주민 관점은 캐나다와 호주와 같은 국가에서 기업 합병에 어떤 영향을 미치나요?

- Answer

- NaiveRAG: 소유권과 협업에 대한 원주민 관점은 특히 자원과 토지 권리가 있는 캐나다와 호주와 같은 국가에서 기업 합병을 형성하는 데 중요한 역할을 합니다

원주민 주권 및 문화적 가치와 교차합니다. 이러한 관점은 커뮤니티 참여, 전통적인 토지 사용에 대한 존중, 자원 관리에 대한 협력적 접근 방식을 강조하여 기업 전략과 결과에 영향을 미칩니다.

. . .

양국은 원주민 관점을 우선시하는 것이 더 지속 가능하고 공평한 결과로 이어진다는 것을 보여줍니다. 원주민 권리를 인정하고 협력 관계를 구축하면 갈등을 줄이고 기업 평판을 높일 수 있습니다. 궁극적으로 원주민 관점을 통합하는 것은 더 나은 비즈니스 관행과 커뮤니티 관계로 가는 길입니다. - LightRAG: 기업 합병에서 소유권과 협력에 대한 원주민 관점 원주민 관점은 캐나다와 호주와 같은 국가에서 기업 합병에 큰 영향을 미칩니다. 이러한 관점은 토지와 자원에 대한 공동체의 권리, 환경에 대한 영적 연결, 경쟁보다 협력의 중요성을 강조합니다.

토지 소유의 문화적 중요성 [...]

협업의 역할 [...]

법률 및 규제 프레임워크 [...]

결론: 원주민 관점은 공동 소유와 협력 파트너십을 강조함으로써 기업 합병을 형성합니다. 기업은 원주민 문화적 가치와 권리를 존중하는 존중받는 포용적 관행을 채택하여 지속 가능하고 상호 이익이 되는 결과를 위한 길을 열어야 합니다.

- NaiveRAG: 소유권과 협업에 대한 원주민 관점은 특히 자원과 토지 권리가 있는 캐나다와 호주와 같은 국가에서 기업 합병을 형성하는 데 중요한 역할을 합니다

- LLM Decision 평가

- Comprehensiveness: LightRAG 는 문화적 중요성, 협업, 법적 틀을 논의하여 원주민 관점에 대한 철저한 탐구를 제공하며, 구체적인 사례와 세부적인 인사이트를 포함합니다. 반면, NaiveRAG 은 유익하지만 소유권과 협업에 대한 원주민 관점의 다양한 차원을 분석하는 데 있어 동일한 깊이가 부족합니다.

- Diversity: LightRAG는 토지 소유권의 공동 측면, 영적 연결, 실질적인 협업 사례에 초점을 맞춘 더 넓은 범위의 관점을 제시합니다. 이는 원주민 관점을 서양의 개념과 대조하여 더 많은 지면을 다루지만, NaiveRAG 은 주로 제한된 관점을 가진 기업 전략과 결과에 초점을 맞춥니다.

- Empowerment: LightRAG는 협업의 중요성과 관련된 법적 프레임워크를 강조하여 독자에게 미묘한 이해와 실행 가능한 인사이트를 제공합니다. 포괄적인 접근 방식을 채택하면 더 나은 결과를 얻을 수 있는 방법을 설명함으로써 기업에 힘을 실어줍니다. NaiveRAG은 실용적이지만 도덕적 또는 윤리적 함의를 그다지 강조하지 않습니다.

- Overall Winner: LightRAG는 원주민 관점에 대한 실행 가능한 인사이트와 기업 합병에서의 협력 덕분에 포괄적인 탐구, 다양한 관점, 독자의 역량 강화 덕분에 전반적으로 뛰어납니다. 비록 NaiveRAG의 답변이 더 직접적이지만 (Directness), LightRAG의 답변은 깊이와 폭이 더 강력합니다.

Reference

[31] Improving language models by retrieving from trillions of tokens (ICML 2022)

[42] Expand, rerank, and retrieve: Query reranking for open-domain question answering (ACL 2023)

[43] Surfacebased retrieval reduces perplexity of retrieval-augmented language models (ACL 2023)

[41] Generation-augmented retrieval for open-domain question answering (ACL 2021)

[35] Searching for best practices in retrieval-augmented generation (EMNLP 2024)